Mi padre me enseñó a manejar. Recuerdo las sesiones muy de madrugada en donde recorríamos calles vacías para ensayar el arranque, los cambios, la frenada. Esa rutina la repetí con mi hija y me acuerdo que transmití las mismas instrucciones para la prueba reina del manejo: el parqueo lateral.

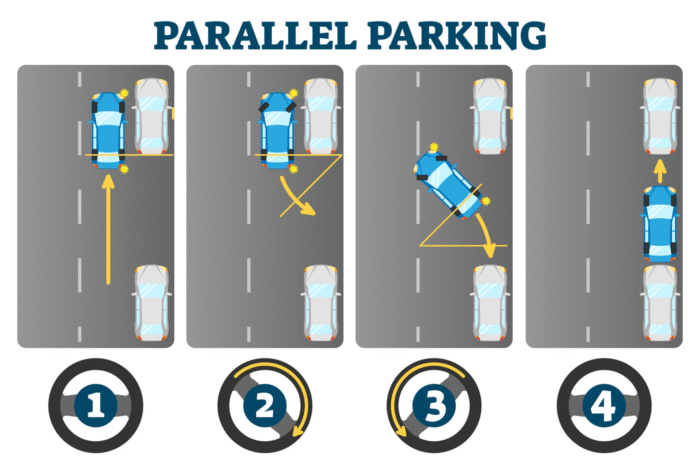

«Te ubicas muy cerca del vehículo de adelante de manera que la llanta trasera esté alineada con la parte de atrás, le das toda la dirección a la derecha y retrocedes, cuando ves que has pasado la parte de atrás le das toda la direccción a la izquierda, entras y corriges».

O algo así.

La instrucción en palabras es complicadísima de expresar y esta habilidad sólo se aprende en el terreno, sintiendo las distancias, capturando con todos los sentidos el momento, concentrándose en la acción y repitiendo hasta la perfección.

Dentro de unos cinco años, (si todavía estoy en este lado del universo) me encantaría repetir la escena con mi nieta. Soltar las riendas, aguantar la respiración y dejar que realice la maniobra por sí misma. Será un ritual de transmisión de mando de una generación a otra que tiene mucho valor y mucho significado.

Seguramente los lectores tendrán recuerdos similares y la obtención de la licencia de conducción, que en Colombia llamamos «el pase», tiene una connotación clara de permiso, de logro. Podemos pensar que el mundo se abre en un rito de iniciación que nos autoriza para entrar en la adultez. Los padres, y la sociedad, nos están diciendo: «Te entregamos esta máquina de tonelada y media y te confiamos la vida de tus amigos y la tuya. Contamos con tu buen juicio y tu madurez».

Esta confianza no era trivial. Nos preparábamos para ese momento con horas de práctica, aprendiendo las reglas, los límites y, sobre todo, a anticipar los errores de los demás. Aprendimos a sentir la carretera a través del volante, a entender la física del movimiento, a calcular las distancias en una fracción de segundo. La primera vez que un neumático se pinchó en una carretera solitaria, no había un «botón de pánico». Había una llanta de repuesto, un gato oxidado y una lógica en cada paso. Y lo resolvimos. Esos 15 minutos de trabajo sucio bajo el sol nos enseñaron más sobre la independencia y la capacidad de resolver problemas que muchas clases.

Manejar un carro no es sólo una habilidad técnica; es un acto social de gran significado. Es llevar a tu hijo al colegio, es llevar a una amiga al aeropuerto, es el acto de gran responsabilidad de llevar a un ser querido de forma segura a su destino. También es el medio de subsistencia para millones de personas. Pensemos en los taxistas, los conductores de Uber y, por supuesto, los camioneros. Hombres y mujeres que no son sólo «trabajadores» sino la columna vertebral de nuestra sociedad, con una ética de trabajo y un sentido de responsabilidad que mantiene las ciudades y las economías en movimiento.

Puede pensarse que es una tontería, pero la IA nos quiere quitar todo eso. Hoy, la tecnología nos dice que eso es un «problema» que debe ser resuelto por una máquina.

No me imagino qué vendrá después. Con el fin de salvar vidas, veremos las carreras de la FÓRMULA CERO, cero conductores.

Que un ser humano esté a cargo de llevar a otro ser humano del punto A al punto B, en un vehículo, de repente se convirtió en una amenaza para la humanidad que debe ser resuelta con una inversión costosísima de talento, ingenio, recursos y muchísimo dinero, en una carrera desaforada que llevará a un accidente social trágico que no tendrá «air bags» que nos salven.

La falacia de la seguridad

En todas las discusiones sobre vehículos autónomos lo primero que sale en la agenda es que millones de personas mueren y se lesionan en accidentes de tránsito. Eso es cierto y también se sabe que la gran mayoría de los accidentes son causados por errores humanos: distracción, cansancio, alcohol y simplemente malas decisiones. La promesa de la tecnología autónoma, con su capacidad de reacción constante y su falta de errores humanos, es la de reducir esa cifra, salvando vidas y reduciendo los costos de salud y daños materiales asociados con los accidentes.

¡Felicitaciones! Eso queremos todos.

Pero lo que no se dice es que por cada accidente, hay miles de millones de viajes diariamente que terminan exitosamente sin incidentes. La inmensa mayoría de conductores humanos realizan en este momento recorridos rutinarios sin ningun problema. En una ciudad como Nueva York, se estima que un accidente mortal ocurre, en promedio, sólo una vez por cada millón de viajes.*(Eso me dijo Gemini) Un riesgo infinitesimal.

¿Es justificada una inversión de cientos de miles de millones de dólares para reducir este riesgo casi a cero, a costa de desplazar un ejército de trabajadores y de reconfigurar toda la infraestructura urbana? Para que esta solución funcione y tenga algún efecto en las estadísticas de accidentes, tendría que reemplazar TODOS los vehículos que andan hoy por las carreteras y calles de las ciudades.

Y para resolverlo se están introduciendo una cantidad de variables que multiplican la probabilidad de las fallas.

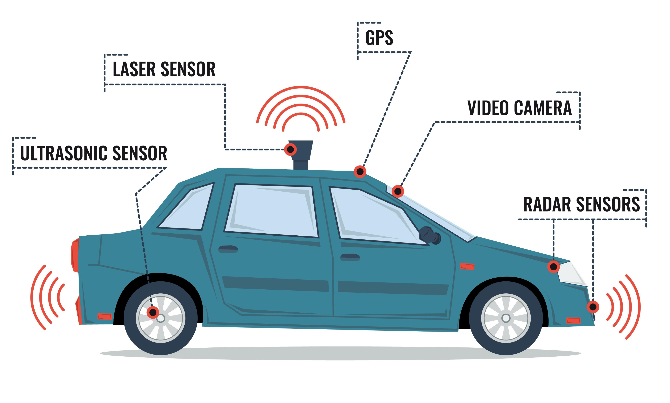

Los vehículos tradicionales tienen hoy tres niveles de operación que pueden fallar: el nivel mecánico, el nivel eléctrico y el nivel humano. En el caso de los autónomos se tienen seis niveles: mecánico, eléctrico, electrónico (hardware), software (bugs), IA (decisiones equivocadas) y el nivel humano (corporativo como explicaremos más adelante).

Los niveles mecánico y eléctrico de los vheículos llevan más de un siglo de perfeccionamiento tecnológico y aun así no dan una garantía plena de estar libres de fallas. Los demás niveles son prácticamente jóvenes en la historia de la humanidad: la electrónica y la informática tienen tres cuartos de siglo y la novedosa IA es un bebé (que crece exponencialmente, por cierto) pero que todavía necesita madurar.

Matemáticamente esto significa mayores riesgos de fallas. Veamos.

Imaginemos que la probabilidad de falla de un solo componente es 0.01% es decir 0.0001 o uno en diez mil. Compras diez mil limones y uno te sale picho. Muy bien.

- La probabilidad de falla P(F) = 0,01%

- La probabilidad de que no falle (NF) será P(NF) = 1 − 0,01% = 1 − 0.0001 = 0.9999

Ahora imaginemos que tenemos 100 componentes así de buenos. La probabilidad de que todo el sistema no falle es el producto (no la suma) de todas las probabilidades de que ninguno falle:

- P(NF) = P1(NF) x P2(NF) x ….. x P99(NF) x P100(NF)

- P(NF) = 0,9999 x 0,9999 x …. = (0,9999)100 ≈ 0.990049

- P(F) = 1 − P(NF) = 1 − 0.990049 ≈ 0.009951

(La probabilidad de que el sistema falle es ahora 0,9951 % o aproximadamente 1%)

Pero un sistema autónomo agrega unos 10.000 componentes al vehículo, supuestamente de calidad máxima, es decir de especificaciones militares, es decir muy costosos, lo que nos da la siguiente ecuación:

- P(NF) = 0,9999 x 0,9999 x …. = (0,9999)10.000 ≈ 0.36786

- P(F) = 1 − P(NF) = 1 − 0.36786 ≈ 0.632139

(La probabilidad de falla de todo el sistema es ahora 63,21%)

Así que subirse en un carro autónomo y que todo funcione perfectamente tiene una probabilidad mucho menor que lanzar una moneda al aire. Y esto solamente cubre los elementos físicos del sistema. No hemos hablado del software.

De nuevo, con la ayuda de Gemini, hemos aprendido que un sistema de manejo autónomo incluye millones de líneas de código que permiten al vehículo interpretar los datos de los sensores, tomar decisiones, planificar rutas y controlar los sistemas del vehículo (aceleración, frenado, dirección).

¿Alguna vez te ha fallado el software de tu PC o de tu maravilloso teléfono inteligente?

Al agregar la palabra software a un sistema, estamos trayendo muchos fantasmas: bugs (fallas en la programación), malware (virus perversos), ciberataques (humanos perversos), reinicios inesperados (un rayo cercano produce un hipo en el sistema), pérdida de la conexión (en un túnel), desactualización (versiones, tras versiones, tras versiones), corrupción de datos (incorrectos, incompletos, inoportunos).

Pero sobretodo, estamos soltando el timón (algunos vehículos autónomos no traen timón) a un sistema que puede tomar decisiones equivocadas y que está siendo desarrollado por humanos que ya han tomado decisiones equivocadas en el pasado. Veamos…

¿Pondrías a tu hijo en un vehículo autónomo? La desconfianza en la industria automotriz

La pregunta no es gratuita. Y para responderla hay que revisar el oscuro historial de una industria que ha demostrado, una y otra vez, que la codicia a menudo supera a la responsabilidad. Su historia no es una cadena de avances impecables, sino de fallas catastróficas, negligencia corporativa y una lucha constante por la confianza del público.

En el ANEXO1 hemos recopilado (con la ayuda de Gemini) una serie de casos en los que las muertes automovilísticas han sido causadas por errores humanos, pero no en el asiento del conductor sino en las mullidas sillas de las salas de juntas de los ejecutivos de las grandes empresas de carros. Cedo la palabra a Gemini:

Pensemos en el caso del interruptor de encendido de General Motors. No fue un error de software futurista, sino un fallo de una simple pieza mecánica que activaba un efecto dominó fatal. El interruptor, por un defecto de diseño, podía apagarse de forma inesperada si la llave colgaba un peso o el vehículo pasaba por un bache. Cuando el motor se apagaba, los frenos de potencia y la dirección asistida dejaban de funcionar. Pero lo más grave es que los airbags se desactivaban, dejando al conductor y a los pasajeros indefensos en caso de colisión. Lo que hace que este caso sea un presagio ominoso para la era autónoma es que GM, la empresa que hoy invierte en la conducción sin conductor, sabía del defecto desde hacía más de una década. Documentos internos mostraron que los ingenieros discutieron el problema, pero la empresa decidió no arreglarlo por los costos. El resultado: 124 muertes y cientos de lesiones, que sólo salieron a la luz después de que un acuerdo con el Departamento de Justicia de EE. UU. sacara a la luz la verdad.

Y, por supuesto, no podemos olvidar la saga de los airbags de Takata. En el que es quizás el retiro de vehículos más grande de la historia, más de 100 millones de vehículos de 19 fabricantes diferentes se vieron afectados. El defecto: el inflador del airbag podía explotar con demasiada fuerza, lanzando fragmentos de metal al interior del vehículo, causando decenas de muertes. La falla no fue un simple defecto de fabricación, sino un problema con la composición química del inflador que se degradaba con el tiempo. De nuevo, la industria lo sabía. Takata y algunos fabricantes fueron acusados de ocultar el defecto durante años, priorizando la producción sobre la seguridad.

Estos casos son un recordatorio que da miedo porque nos muestra que incluso la tecnología más probada y los fabricantes más grandes pueden tomar decisiones equivocadas que cuestan vidas. Y lo que es peor, nos enseñan que hay una tendencia corporativa a ocultar estos errores por razones económicas.

Ahora, se nos pide que pongamos nuestra fe no en un interruptor o en un airbag, sino en una combinación de sensores de alta gama, complejos algoritmos de software y la propia Inteligencia Artificial. Los desarrolladores argumentan que sus sistemas son «más seguros», que están diseñados con redundancia y que no cometerán los errores de un conductor humano.

Pero, como demuestran los retiros de vehículos de Tesla y BMW por fallos de software, la tecnología no es infalible. Y, a diferencia de un conductor, la responsabilidad en un accidente causado por un vehículo autónomo es una nebulosa legal que aún no se ha resuelto.

El debate sobre la conducción autónoma no es sólo sobre datos de accidentes o la viabilidad económica. Es un debate sobre la confianza. Si la industria automotriz ha demostrado ser capaz de ocultar fallos mortales en la era de los vehículos mecánicos y electrónicos, ¿qué garantías tenemos de que no ocultarán un fallo en el software de un vehículo autónomo?

La pregunta no es si la tecnología puede, en teoría, ser más segura que un humano. La pregunta es si la industria que la desarrolla puede ser más honesta y transparente que la industria que nos trajo el interruptor de encendido de GM. Y hasta que esa pregunta tenga una respuesta clara, la idea de poner a nuestros hijos en un vehículo que se conduce sólo será, para muchos de nosotros, un salto de fe que estamos lejos de poder dar.

La euforia tecnológica y la presión de los inversionistas.

Otro argumento que se ha presentado es que la «emoción» de los tecnólogos por introducir estas soluciones de autonomía de vehículos es uno de sus principales peligros ya que es muy «entretenido» imaginar estas soluciones tan maravillosas y mágicas, pero eso les hace ignorar las críticas o los argumentos racionales y defienden sus ideas con tanta efervecencia que incluso insultan a los que están en contra con calificativos desobligantes.

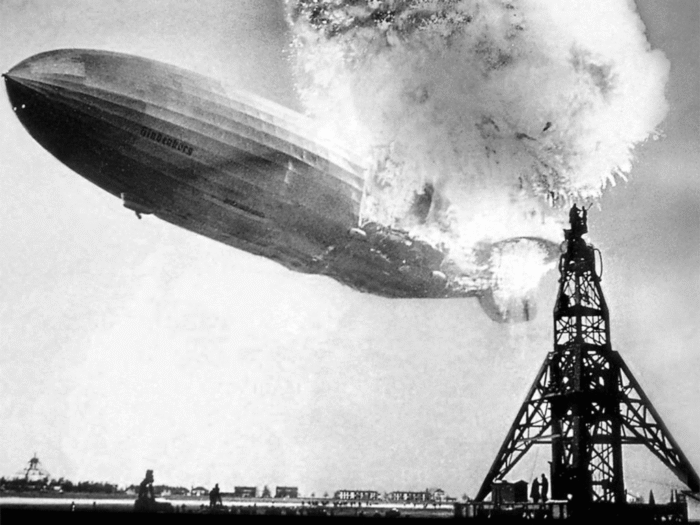

Esto es muy parecido a lo que ocurrió con la tecnología del Zepelin que terminó con la tragedia del Hindenburg porque los tecnólogos no escucharon las alarmas de quienes eran más racionales y decían que era absurdo llevar a decenas de personas debajo de una bomba inflamable de hidrógeno. ¿Pasará lo mismo con los autónomos? Un accidente con un niño muerto podría «matar» toda la industria.

La historia del Hindenburg es un ejemplo clásico del sesgo de confirmación. Los desarrolladores de los zepelines estaban tan convencidos de que su tecnología era el futuro del transporte aéreo que ignoraron las advertencias sobre el uso de hidrógeno. El hidrógeno era mucho más barato y más fácil de obtener que el helio (el gas inerte y seguro). La emoción por la «magia» de volar y la oportunidad de negocio hizo que se subestimaran los riesgos inherentes a un gas tan inflamable. El resultado fue la tragedia que marcó el fin de la era de los zepelines de pasajeros.

Sé que me calificarán de ave de mal agüero y de enemigo del progreso de la humanidad, pero hay muchos indicios que me ponen a dudar de que los vehículos autónomos son el camino correcto e inteligente de resolver los problemas que sufre la sociedad por haber elegido la solución de los automóviles y camiones para su desarrollo económico.

Por supuesto que las novedades de seguridad que complementan la conducción y mejoran las probabilidades de sobrevivir un accidente o de evitar que éste suceda son absolutamente bienvenidas y necesarias, pero la eliminación del conductor no es el camino.

Existen soluciones mejores. Mayor capacitación de los conductores; menores jornadas de trabajo; mayores consecuencias a la conducción imprudente o bajo efectos del alcohol; mayor comunicación y mayor control del estado de los vehículos; desestímulo del viaje individual y reemplazo por el transporte público; descentralización y reducción de los viajes; reconfiguración de las ciudades…

En conclusión

La inversión en tecnología autónoma para resolver el problema de los accidentes de tráfico es un argumento que se basa en la premisa de que cualquier vida salvada justifica la inversión, por monumental que sea.

La visión es deslumbrante. Un futuro de vehículos que se deslizan por autopistas y calles sin un alma al volante. Una utopía de carreteras seguras, sin accidentes, sin tráfico. Un mundo donde el viaje de la casa al trabajo no se desperdicia en la frustración de la congestión, sino en la paz de la lectura o la productividad de un correo electrónico. Los tecnólogos de Silicon Valley nos venden esta imagen con el fervor de evangelistas, prometiendo que la Inteligencia Artificial al volante no es sólo una mejora, sino una salvación.

Pero, ¿y si la solución a la que nos dirigen es, en el fondo, una de las ideas más absurdas de nuestro tiempo? ¿Y si esta inmensa inversión en tecnología no es más que una idiotez acelerada, una respuesta elegantísima a un problema que, en su esencia, no exige una solución tan costosa y compleja?

Sin embargo, esa inversión se sustenta sobre una tecnología que intenta solucionar un problema que, en el contexto de miles de millones de viajes exitosos, se podría decir que no es un problema de esa magnitud, y que ignora los beneficios sociales y económicos que los conductores aportan a la sociedad. Es un debate entre la lógica fría de las estadísticas y la realidad social, económica y humana del mundo en el que vivimos.

La solución a la movilidad entre ciudades y dentro de las ciudades mismas no está en tener vehículos que se manejen solos sino en tener menos vehículos y hacer que las personas se desplacen en servicios públicos masivos. La economía del vehículo particular es insostenible y los esfuerzos de la tecnología y la IA deberían enfocarse en lograr mejores sistemas de transporte masivo (autónomo o no) más que resolver el viaje individual.

La premisa de «eliminar al conductor» que se promueve en la industria de la IA no es más que una de las tres ideas más peligrosas de nuestra era. Se suma a la de «eliminar al artista», con la creación de arte por IA, y a la de «eliminar al que atiende al cliente» con los robots y chatbots. Estas tres premisas están resolviendo lo que no necesita ser resuelto. Están atacando no una deficiencia, sino una parte fundamental de la experiencia humana, la expresión artística, el trabajo social y el sentido de la responsabilidad.

La euforia por el progreso tecnológico es entendible, pero no puede ser ciega. La promesa de un mundo sin accidentes, aunque atractiva, ignora la vida real de miles de millones de viajes que se realizan sin incidentes. Eliminar al conductor es, en un sentido profundo, eliminar una parte de la vida. Es negarle a las nuevas generaciones la oportunidad de aprender esa habilidad vital, de enfrentarse a un desafío y resolverlo por sí mismos.

La promesa de la autonomía vehicular es tentadora, pero es un camino lleno de dilemas complejos. Antes de abrazar esta tecnología como la solución a todos nuestros problemas, debemos ser críticos y honestos sobre sus limitaciones. Quizás la pregunta no es si el vehículo autónomo puede funcionar, sino si realmente lo necesitamos.

La primera falacia es la justificación económica. Se nos dice que la IA reemplazará al conductor, que es la pieza más «económica» del sistema. Pero esta visión ignora los costos reales de la tecnología. Un vehículo autónomo no sólo tiene un precio inicial altísimo, que puede ser de decenas de miles de dólares más que un vehículo convencional. También requiere una infraestructura de respaldo que, como hemos visto, se asemeja más a un sistema militar que a un garaje de barrio. ¿Qué sucede cuando un neumático se pincha en la autopista? La máquina no puede cambiar la llanta. La solución no es tecnológica, sino logística: se debe enviar un equipo de asistencia especializado. ¿Y qué pasa con una persona mayor que necesita ayuda para subir al vehículo con su equipaje? La máquina no tiene brazos, ni empatía. Se necesita, de nuevo, un asistente humano.

Hay un patrón histórico que nos advierte sobre esta euforia tecnológica. La historia de los zepelines, que terminaron con la tragedia del Hindenburg, es un claro recordatorio de cómo la emoción por una tecnología «mágica» puede nublar el juicio racional. En su deseo por hacer volar a los pasajeros sobre un gas más barato, los ingenieros ignoraron las advertencias de los escépticos. El resultado fue el final de toda una industria. ¿Será un accidente con un vehículo autónomo, especialmente uno que involucre la vida de un niño, el Hindenburg de esta nueva era?

La solución a nuestros problemas de movilidad, como argumentan los urbanistas, no está en una legión de vehículos que se conducen solos, sino en tener menos vehículos en las carreteras. No es una cuestión de tecnología, sino de política social. La inversión de la IA debería estar enfocada en sistemas de transporte masivo más eficientes y accesibles, que reduzcan la congestión y el impacto ambiental, en lugar de perpetuar el modelo insostenible del vehículo individual.

Y finalmente, ¿quién pagará por todo esto? La paradoja de la automatización nos persigue. Si la IA deja sin trabajo a millones de taxistas, repartidores y conductores, ¿quién tendrá el poder adquisitivo para pagar por estos servicios tan sofisticados? El futuro que nos pintan es un paisaje de autopistas pulcras, pero vacías. Un sistema que se perfecciona a sí mismo hasta el punto de que ya no hay clientes para el servicio que ofrece.

La IA no es una idiotez. Es una herramienta poderosa y maravillosa. Pero en el caso de los vehículos autónomos, la aplicación de esta inteligencia parece ser una de las manifestaciones más aceleradas de la locura humana: gastar una fortuna para resolver un problema que, en el día a día, no existe para la mayoría de las personas, y en el proceso, crear una serie de nuevos problemas que podrían ser mucho más difíciles de resolver.

Guillermo Ramírez – Agosto 2025

Y una advertencia final

En todas las actividades críticas de nuestra vida digital nos cuestionan si somos robots:

Existe el temor de que las máquinas nos reemplacen para hacer y deshacer en nuestro entorno digital.

Por ahora, estamos protegidos porque en las aplicaciones de IA la intervención de la máquina es mediante un CHAT, una conversación en la que sus respuestas pueden ser aceptadas o no por el humano, quién verá qué hacer con ellas.

La máquina se limita hoy en día a sugerir y todavía no le damos permiso de actuar por nosotros. Ese es el siguiente nivel en el que los agentes podrán tomar decisiones y habrá consecuencias reales de esas decisiones.

Sin embargo, en el caso de los vehículos autónomos, se le está dando permiso y autoridad a la máquina de intervenir en el entorno físico de nuestras ciudades y carreteras con un arma mortal de varias toneladas. ¿Cómo entender esa contradicción?

ANEXO 1

(Contribución de Gemini)

El historial de la industria automotriz está repleto de casos donde la introducción de nuevas tecnologías, especialmente las electrónicas, ha resultado en fallas de diseño o fabricación que han requerido retiros masivos (recalls). Esto demuestra que incluso en un entorno de desarrollo controlado, los errores son una posibilidad real y peligrosa.

Aquí hay algunos de los casos más notables y relevantes, tanto recientes como históricos, que ilustran este punto:

1. El caso del pedal de aceleración de Toyota (2009-2010)

Este es quizás uno de los casos más famosos de fallas que involucraron un componente electrónico y causaron preocupación por la seguridad. Toyota tuvo que retirar del mercado más de 8 millones de vehículos en todo el mundo.

- Falla: La compañía recibió quejas de que algunos vehículos experimentaban una «aceleración involuntaria», lo que en algunos casos llevó a accidentes mortales. La causa inicial se atribuyó a pedales de aceleración que se quedaban atascados o a alfombrillas que interferían con el pedal.

- Problema electrónico/software: Una investigación posterior de la NHTSA (Administración Nacional de Seguridad del Tráfico en Carreteras de EE. UU.) y la NASA no encontró un problema electrónico a gran escala, pero la controversia destacó cómo la complejidad de los sistemas electrónicos de los vehículos modernos puede ser difícil de diagnosticar y puede causar graves problemas de seguridad.

2. El escándalo de los airbags de Takata (2013-presente)

Este es un caso masivo de fallas que ha afectado a casi todos los fabricantes de automóviles y ha causado decenas de muertes a nivel mundial.

- Falla: Los infladores de los airbags de la compañía Takata podían explotar con demasiada fuerza, lanzando fragmentos de metal a los ocupantes del vehículo. La causa era un producto químico usado en el inflador que se degradaba con el tiempo y con la exposición a la humedad.

- Alcance: Este ha sido el retiro del mercado más grande en la historia automotriz, afectando a más de 100 millones de vehículos de al menos 19 fabricantes diferentes.

3. Retiros recientes por fallas en el software

En la era moderna, con el aumento de los sistemas electrónicos y de software en los vehículos, los «recalls» por fallos de software son cada vez más comunes.

Ford (2024): Ford retiró más de 330,000 vehículos debido a un defecto de seguridad.

BMW (2022): La compañía retiró del mercado más de 70,000 vehículos eléctricos debido a un error de software que podía causar que el sistema de alto voltaje se apagara repentinamente, lo que resultaba en la pérdida de potencia del vehículo.

Tesla (2023): Tesla retiró del mercado más de 362,000 vehículos equipados con el software Full Self-Driving (FSD) Beta. La NHTSA indicó que el software podría permitir que los vehículos actuaran de manera insegura en las intersecciones, como exceder la velocidad permitida o no detenerse por completo en las señales de stop. Aunque no se reportaron muertes en este caso, la falla tenía el potencial de causar accidentes graves.

4. El problema con el interruptor de encendido de GM.

Uno de los más notorios y trágicos en la historia reciente de la industria automotriz llevó a un retiro masivo de millones de vehículos y causó numerosas muertes.

- La falla: El defecto de diseño en el interruptor de encendido era que, si una llave pesada o un bache en la carretera provocaban que la llave se girara, el motor se apagaba repentinamente.

- Consecuencias catastróficas: Cuando el motor se apagaba mientras el vehículo estaba en movimiento, se producían varias fallas en cadena. La dirección asistida y los frenos de potencia dejaban de funcionar, lo que hacía que el conductor perdiera casi por completo el control del vehículo. Lo más grave, sin embargo, era que el apagado del motor también desactivaba los airbags, dejándolos inoperables en caso de un choque.

- Encubrimiento: Lo que hizo que este caso fuera tan notorio fue que GM tuvo conocimiento del defecto por más de una década antes de emitir un retiro del mercado. Documentos internos mostraron que los ingenieros de la compañía discutieron el problema, pero la empresa decidió no tomar medidas, en gran parte por los costos asociados a un rediseño de la pieza.

- El resultado y el acuerdo legal:

Retiros masivos: El caso salió a la luz pública en 2014, lo que obligó a GM a realizar uno de los retiros del mercado más grandes de su historia, afectando a más de 30 millones de vehículos en todo el mundo.

Muertes confirmadas: Inicialmente, GM reconoció un número muy bajo de muertes, pero un fondo de compensación creado por la compañía terminó reconociendo 124 muertes y cientos de lesiones relacionadas con el defecto.

Consecuencias legales y financieras: GM enfrentó fuertes críticas, demandas, y multas multimillonarias. La empresa pagó 900 millones de dólares en un acuerdo con el Departamento de Justicia de EE. UU. y tuvo que desembolsar una cantidad similar en compensaciones a las víctimas y sus familias.

5. El dieselgate de Volkswagen

El caso «dieselgate» es uno de los mayores escándalos en la historia de la industria automotriz y un ejemplo claro de la falta de confianza que puede generar una corporación. Se originó en 2015 cuando se descubrió que el Grupo Volkswagen había manipulado los resultados de las pruebas de emisiones de sus vehículos diésel.

- Detalles del caso: El fraude consistió en la instalación de un software ilegal, conocido como «dispositivo de desactivación», en los motores diésel (EA189) de aproximadamente 11 millones de vehículos en todo el mundo. Este software era capaz de detectar si el coche estaba siendo sometido a un test de emisiones en un laboratorio. Durante las pruebas, el software activaba los sistemas de control de emisiones para que el vehículo cumpliera con los estándares de óxido de nitrógeno (NOx). Sin embargo, una vez en la carretera, el software desactivaba estos sistemas, permitiendo que el coche emitiera hasta 40 veces más NOx de lo permitido. La alta emisión de NOx mejoraba el rendimiento y la eficiencia del motor, pero a costa de una severa contaminación del aire. El engaño fue descubierto por un pequeño equipo de investigación de la Universidad de West Virginia en Estados Unidos.

Consecuencias: - Multas y sanciones: Volkswagen ha pagado decenas de miles de millones de dólares en multas, acuerdos y compensaciones. Sólo en Estados Unidos, la compañía acordó pagar más de 25 mil millones de dólares en reparaciones, recompras de vehículos y sanciones. La multa también se extendió a otras marcas del grupo, como Audi y Porsche, y a ejecutivos condenados a prisión.

- Reputación y confianza: El escándalo causó una pérdida catastrófica de confianza en la marca Volkswagen, que había sido sinónimo de calidad y confiabilidad. Los consumidores se sintieron traicionados y la imagen de la marca se vio gravemente afectada.

- Repercusiones ambientales: Las emisiones adicionales de óxido de nitrógeno contribuyeron significativamente a la contaminación del aire y se han relacionado con miles de muertes prematuras y problemas respiratorios.

- Impacto en la industria: El «dieselgate» aceleró la transición hacia los vehículos eléctricos, ya que el público y los reguladores se volvieron extremadamente escépticos sobre la viabilidad del diésel como una opción limpia. También llevó a una revisión global de los protocolos de prueba de emisiones, obligando a las autoridades a implementar tests en condiciones reales de conducción.

ANEXO 2

(Contribución amable de Gemini)

Al día de hoy, ninguna de las principales empresas de vehículos autónomos ha logrado la rentabilidad. Todas están en una fase de inversión masiva y quema de capital (cash burn) para desarrollar la tecnología y escalar sus operaciones. El consenso general es que todavía faltan varios años para que el modelo de negocio demuestre su viabilidad financiera. Este es un resumen de las principales empresas y su situación actual:

1. Waymo (Alphabet/Google)

- Descripción: Es uno de los líderes indiscutibles del sector. Waymo ha estado operando un servicio de «robotaxi» en ciudades como Phoenix, San Francisco y Los Ángeles. Su tecnología es considerada una de las más avanzadas del mundo.

- Resultados financieros: Waymo no divulga sus resultados financieros de forma independiente, ya que forma parte de Alphabet (la matriz de Google). Sin embargo, se sabe que ha operado con pérdidas multimillonarias. Alphabet ha invertido miles de millones de dólares en la empresa, y Waymo ha levantado capital externo en rondas de financiación muy grandes. En 2024, Alphabet se comprometió a invertir hasta 5.000 millones de dólares adicionales en Waymo, lo que indica la magnitud de la inversión requerida.

- Pronóstico: Se espera que Waymo sea una de las primeras empresas en alcanzar la rentabilidad, pero aún no se sabe cuándo. Su valoración ha crecido significativamente, pero su rentabilidad sigue siendo un «punto de interrogación» para los analistas.

2. Cruise (General Motors)

- Descripción: Propiedad de General Motors, Cruise también ha estado operando un servicio de robotaxi, principalmente en San Francisco. La empresa ha logrado avances significativos y ha recibido una inversión masiva de GM y otros socios.

- Resultados financieros: Al igual que Waymo, Cruise ha registrado pérdidas sustanciales. En sus últimos informes, General Motors ha reportado pérdidas trimestrales de cientos de millones de dólares en la operación de Cruise. La empresa ha tenido que enfrentar desafíos regulatorios y de seguridad que han afectado su operación y han incrementado sus costos.

- Pronóstico: Tras un incidente grave en 2023, la empresa detuvo sus operaciones y ha estado trabajando para reconstruir la confianza y reestructurar su negocio. Esto ha retrasado su camino hacia la rentabilidad de manera significativa.

3. Motional (Hyundai y Aptiv)

- Descripción: Motional es una empresa conjunta entre el fabricante de automóviles Hyundai y el proveedor de tecnología Aptiv. Su enfoque es desarrollar la tecnología y licenciarla a otros fabricantes.

- Resultados financieros: Motional tampoco ha divulgado resultados financieros de forma pública, pero opera con grandes pérdidas que están siendo cubiertas por sus socios.

- Pronóstico: Su modelo de negocio es diferente, ya que no buscan operar la flota directamente, sino vender su tecnología. Esto podría permitirles alcanzar la rentabilidad más rápido si logran cerrar contratos con fabricantes de automóviles.

4. Zoox (Amazon)

- Descripción: Zoox, una subsidiaria de Amazon, se enfoca en el desarrollo de un vehículo autónomo diseñado desde cero (sin conductor ni pedales) para el servicio de robotaxi.

- Resultados financieros: Amazon no desglosa los resultados financieros de Zoox. Se presume que la inversión es multimillonaria.

- Pronóstico: Su modelo de negocio se alinea con la estrategia de Amazon de revolucionar la logística y la última milla. La rentabilidad podría ser una meta a largo plazo, ya que el valor para Amazon podría estar en la eficiencia que la tecnología autónoma aportaría a su ecosistema de entrega de productos, más que en el servicio de transporte de personas en sí mismo.

Para los inversionistas

Para los inversionistas, el panorama es claro: la industria de los vehículos autónomos es una carrera de maratón, no un sprint. La tecnología todavía está en una fase de desarrollo y madurez, y los costos iniciales de investigación, desarrollo y construcción de infraestructura son inmensos. No hay una empresa que esté dando resultados positivos a día de hoy. El retorno de la inversión se medirá en años, e incluso décadas. Las empresas que sobrevivirán y prosperarán serán aquellas que tengan un respaldo financiero muy fuerte (como Alphabet y Amazon) y que puedan resistir el alto costo de la inversión a largo plazo.

ANEXO 3

(Sí, también de Gemini)

10 Escenarios donde un conductor humano podría prevenir un accidente

- Daño físico a un sensor: Una bandada de pájaros o un objeto volador golpea y destruye el sensor LiDAR o una cámara frontal. El sistema autónomo podría no tener una redundancia suficiente para compensar la pérdida de datos, pero un conductor humano, al perder la visión de la carretera, podría reaccionar instantáneamente, reducir la velocidad y detener el vehículo de forma segura.

- Falla del sistema electrónico por interferencia electromagnética: Un rayo cercano o una fuerte interferencia electromagnética (EMI) causan una falla momentánea o un «espasmo» en la unidad de control del vehículo. Un conductor humano, aunque sorprendido por la falla, mantendría el control físico del volante y los frenos, y tomaría la decisión de orillarse o continuar con cuidado, mientras que el sistema autónomo podría tener un comportamiento errático o impredecible.

- Bugs de software: Un error de programación (bug) hace que el vehículo malinterprete una señal de tráfico, por ejemplo, que confunda una luz roja con una verde. Un conductor humano, al ver la luz real, corregiría el error del sistema inmediatamente y evitaría una colisión.

- Malware o ciberataque: Un hacker logra acceder al sistema del vehículo y toma el control de los frenos o la dirección. Un conductor humano, al sentir que el vehículo no responde a sus comandos, podría tomar el control físico, apagar el vehículo de forma de emergencia o incluso intentar frenar con el freno de mano, evitando que el hacker cause un accidente.

- Pérdida de la señal de GPS: El vehículo pierde la señal de GPS en un túnel largo o en una zona de alta interferencia. El sistema autónomo podría perder la orientación y tener problemas para navegar, mientras que un conductor humano, con su conocimiento del entorno y su memoria de la ruta, continuaría el camino sin problemas.

- Un objeto inesperado en la carretera: Un colchón, una caja o un mueble caen de un camión en movimiento. Aunque los sensores del vehículo autónomo podrían detectarlo, la IA podría tomar una decisión conservadora de frenar de golpe, lo que causaría un accidente por detrás. Un conductor humano, con su experiencia, podría tomar una decisión más matizada, como esquivarlo de manera segura o frenar de forma progresiva.

- Condiciones climáticas extremas: Una tormenta de nieve inesperada cubre las líneas de la carretera y los sensores del vehículo con hielo. El sistema autónomo podría perder las referencias visuales para mantenerse en el carril. Un conductor humano, al sentir la pérdida de tracción y ver las condiciones, adaptaría su conducción para mantener la seguridad.

- Comportamiento errático de un peatón o un animal: Un peatón corre inesperadamente a la carretera, o un animal cruza en una zona sin visibilidad. Un conductor humano podría usar su instinto y su capacidad de anticipación para tomar una acción evasiva que la IA no estaba programada para predecir, por ejemplo, tocar el claxon para advertir al peatón.

- Falla en los mapas digitales: El mapa digital de alta definición del vehículo autónomo está desactualizado o tiene un error que indica que una calle de un solo sentido es de doble sentido. El vehículo podría intentar girar en contra del tráfico. Un conductor humano, al ver la señal de «sentido prohibido», ignoraría la instrucción del mapa y seguiría la ruta correcta.

- Desconexión del sistema de comunicación de la flota: En un evento de emergencia masiva (por ejemplo, un terremoto), el sistema de comunicación de la flota se cae. El vehículo autónomo podría quedar aislado y desorientado. Un conductor humano, sin embargo, podría continuar operando, basándose en su propio juicio y en la información visual que recibe del entorno.

¡Compra mi libro!

Para los que prefieren un libro impreso (o digital) y les gusta pagar por el contenido de los autores (hay gente así…), se les ofrece esa posibilidad y pueden adquirirlo en este enlace: https://abuelo.co/compra-mi-libro/

Libro impreso (Amazon) – 770 páginas – Tapa blanda – COMPRAR – US $36

E-book (Kindle) – 909 páginas – COMPRAR – US $9,99

Libro digital (Flip Book) – 690 páginas – COMPRAR – COP$90 mil (US $22 aprox.).

(Pueden leerlo gratis (antes de comprarlo) en este link: https://publuu.com/flip-book/771477/1965883 ) Su opinión y comentarios serán muy bien recibidos en este newsletter.